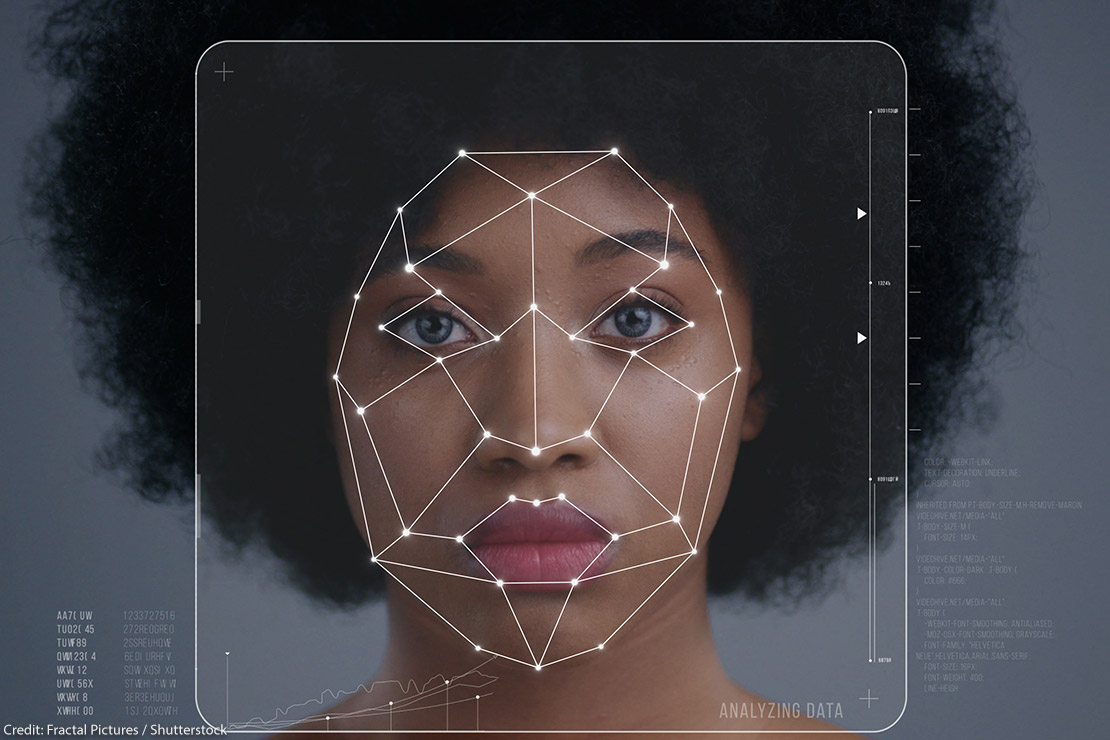

كشفت شركة “ميتا” التكنولوجية الأمريكية، عن آداتها الجديدة المصممة خصيصًا لاكتشاف التحيز العنصري داخل أنظمة الرؤية الحاسوبية، حيث أوضحت العديد من النماذج الخاصة بالرؤية الحاسوبية وجود تحيزًا ملحوظًا وممنهجًا ضد السيدات والأشخاص ذوي البشرة السمراء.

وأوضحت الشركة الأمريكية أنها تأمل أن تساعد الأدوات التي تم تحسينها من قبل المطورين في اكتشاف القصور ومعالجته بشكل أفضل، حيث قدمت “ميتا” للباحثين إمكانية الوصول إلى “FACET” أو العدالة في تقييم الرؤية الحاسوبية، وتلك الأداة تختص بتقييم جودة أداء نماذج الرؤية الحاسوبية من خلال خصائص مختلفة، مثل لون البشرة.

وأشارت الشركة الأمريكية، إلى أن خاصية “FACET” تعتمد على عدد صور يتخطى الـ 30 ألف صورة وتحتوي على 50 ألف شخص تم تصنيفها من قبل الخبراء عبر الفئات الديموغرافية المختلفة، لافتة إلى أنه من الممكن استخدام الآداة أيضًا للإجابة على الأسئلة، مثل هل المحرك أفضل في التعرف على المتزلجين عندما يكون جنسهم المتصور ذكرًا أو غير ذلك.

جدير بالذكر، أن “ميتا” تواصل العمل على تطوير أدوات الذكاء الاصطناعي، على الرغم من اعترافها بأضراره المحتملة.

اترك تعليق